Per portare effettivamente valor aggiunto ai processi aziendali, non è sufficiente riempire il proprio sistema di sensori, serve anche sapersi districare tra concetti come IoT, big data, digital twin.

Gemello digitale, analytics, big data, IoT e digitalizzazione rappresentano oggi i mantra di quella che viene chiamata Industria 4.0 (da quando nel 2012 il governo tedesco ha chiesto a rappresentanti della grande industria e della ricerca i loro desiderata «agli inizi della quarta rivoluzione industriale»). E come tutti i mantra corrono il rischio di essere parole, il cui significato e la cui implementazione non è così immediata. È sicuramente necessario fare un po’ di chiarezza in questo contesto, al fine di ottenere sistemi di raccolta e analisi dati che portino effettivamente valore aggiunto ai processi aziendali.

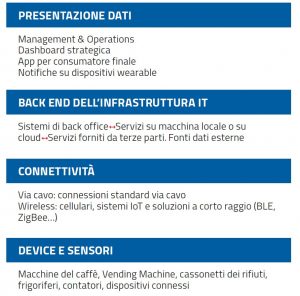

L’architettura di riferimento (di cui vedete lo schema in basso a questa pagina) mette al centro la possibilità di aprire i dati a servizi di analisi dei dati aziendali oppure aprire a terzi parti l’opportunità di servizi con quei dati, che possono creare valore nella misura in cui sono lasciati liberi di creare valore. Non va poi dimenticato che il tema della rappresentazione dei dati è quello più sottovalutato ma forse è la vera chiave del successo, perché se i dati non sono rappresentabili, usabili dagli operatori hanno poche potenzialità. Questa è solo un’architettura di riferimento, ma sicuramente una delle più promettenti che pone il centro nella definizione dei servizi.

Il primo passo

Da dove si inizia? La tentazione è di riempire il sistema di sensori e di sistemi di acquisizione che riversino i dati in un sistema di raccolta. Ma questo, più che creare valore, rischia di portare costi nascosti che alla lunga si rivelano importanti. Il tema chiave non è l’IoT o i protocolli di raccolta dati, che rappresentano una tecnologia abilitante e non il punto chiave. Così come non lo sono i sensori o i sistemi di visione, che ancora una volta sono oggi sempre più promettenti e niente più che una tecnologia abilitante. Ma il punto di partenza è altrove: è il modello matematico/informatico del processo, del macchinario e del prodotto che si vuole monitorare.

Questo è il tema del “gemello digitale”, che ha lo scopo di fornire un livello di conoscenza molto approfondita del fenomeno e nello stesso tempo permette di individuare gli elementi da monitorare al fine di ottenere delle analisi molto accurate. Il gemello virtuale non è altro che il benchmarking che servirà per analizzare i dati raccolti al fine di capire come si discostano le prestazioni effettive da quelle teoriche o di progetto.

Definire delle metriche che permettano di analizzare i propri dati è un processo da fare a priori, perché indubbiamente aiuta a razionalizzare. E quasi tutte le architetture di riferimento sono d’accordo nel mettere al centro questa tecnologia nel processo di raccolta e soprattutto di analisi dei dati. Ma quanto complesso deve essere questo modello digitale? La complessità dipende dalla specificità del fenomeno da monitorare: esistono modelli di simulazione multifisica, modelli black box, sistemi basati su apprendimento (machine learning) e tanto altro.

La metodologia parte dalla realizzazione di un modello matematico del sistema utile come benchmark delle prestazioni. Questo modello, definito in fase di progettazione, è utile alla simulazione del sistema permettendo una prototipazione virtuale precedente alla realizzazione del macchinario, ma una volta validato sul sistema costruito può essere usato come strumento di confronto delle prestazioni.

Fornendo in ingresso al modello i parametri di processo, questi è in grado in tempo reale di fornire le performance attese e nello stesso tempo confrontarle con quelle misurate. Analizzando gli scostamenti tra questi due insiemi di misurazioni per esempio, virtuali e reali, è possibile arrivare a un’ottima determinazione delle performance.

Il cuore è rappresentato dal rendere in grado i clienti, operatori e manager di potere fruire dei dati e di crearne un vero valore. La sfida oggi è imparare a pensare la raccolta e l’analisi dei dati, non un mero fatto tecnologico ma una strategia aziendale fortemente orientata alla creazione del valor aggiunto.

Cloud, big data e analytics non sono sinonimi

Per capire questi concetti è fondamentale osservare che quando si parla di “cloud” per il mondo industriale e non solo, ci si riferisce all’insieme di tecnologie rivolte all’archiviazione, all’elaborazione e alla trasmissione di dati, ma anche di applicativi e di software pervasivi per ottenere informazioni utili ai fini del processo e del controllo distribuito. In altre parole molto spesso si confondono i tre termini cloud, big data e analytics, che caratterizzano tre aspetti molto diversi tra di loro. Il punto di partenza è la grande mole di dati che vengono generati dalla digitalizzazione dei dati proveniente dalle varie attività legate agli oggetti e ai macchinari. Questi dati per complessità, variabilità e volume vanno organizzati, strutturati, raggruppati e filtrati in modo da poter essere maneggiati al fine di ricercare correlazioni ed estrarre informazioni utili, costituendo quello che viene classificato come big data.

I big data non sono semplici dati raccolti in grande quantità, ma devono avere delle caratteristiche ben precise. La mole è sicuramente una di queste, ma non la principale. I dati devono essere complessi e strutturati in modo da dare luogo a delle informazioni utili ai fini delle analisi, e nello stesso tempo devono essere variabili e vari al fine di potere descrivere un fenomeno da tanti punti di vista. E a questo fine concorrono non solo i dati che si possono ottenere da una delle misure su macchinari o processi ma anche dati indiretti e apparentemente scorrelati, che invece si possono rivelare utili per mettere in evidenza fenomeni o problemi mai osservati in precedenza. In pratica si definisce sotto il termine big data sia la mole di dati, che supera il limite fisico dei database tradizionali, sia l’insieme delle tecniche di analisi di quantità incredibilmente grandi di informazioni attraverso tecnologie e metodi analitici specifici. L’analisi avanzata di questi dati ha come obiettivo principale l’estrapolazione di informazioni aggiuntive rispetto a quelle ottenibili dalle sole serie di dati raccolte dal singolo dispositivo: i sistemi IoT (Internet of Things) raccolgono informazioni dagli oggetti a cui poi si aggiungono i dati ricavati da fonti diverse non strutturate come motori di ricerca, blog, social network o altri strumenti di analisi aziendale.

In tutto questo il cloud rappresenta il contenitore non solo dei dati, ma anche delle applicazioni che permettono l’analisi e la visualizzazione delle informazioni, diventando la tecnologia di riferimento per quella che viene chiamata integrazione cyberfisica dei sistemi. Tutte queste tecnologie (IoT, cloud, big data, analytics) concorrono di fatto alla creazione di quello che è il modello matematico del processo fisico in grado di descrivere il processo, il prodotto o il servizio in modo preciso per potere realizzare delle analisi, e applicare delle strategie, che sono di fatto una codificazione di quella che va sotto il nome di intelligenza artificiale.

E la cyber security?

I sistemi industriali e i relativi macchinari sono sempre più dotati di tecnologie che acquisiscono in tempo reale dati dettagliati di funzionamento e li condividono con altri sistemi informatici in rete, in particolare Internet ma anche altre tipologie di reti. In questo il tema della cyber security è molto importante, in quanto sono molti gli elementi da proteggere, dai sistemi embedded alle reti di comunicazione ai sistemi informatici che analizzano e immagazzinano tali dati (per esempio cloud).

Da un lato il paradigma dell’Industria 4.0 richiede un’apertura verso il mondo, al fine di abilitare l’integrazione tra sistemi diversi, dall’altro è fondamentale chiudersi per proteggersi da attacchi e usi impropri dei dati generati e condivisi. Una recente analisi di SANS (Sans 2016 – State of ICS Security Survey) sullo stato della security dei sistemi di controllo industriale (ICS – Industrial Control Systems) indica che il 42% delle minacce ai sistemi arriva dall’interno delle organizzazioni. Qualunque sia la causa è evidente che con il diffondersi dell’IoT, molto spesso derivato dal mondo consumer, ogni dispositivo, sensore, server, client di visualizzazione o periferica è un potenziale punto di accesso. Ma non è sempre facile riconoscere le minacce. Ci si aspetta gruppi di hacker in procinto di entrare nelle nostre aree digitali, ma ci si dimentica dell’operatore di linea che condivide le password con il suo collega non autorizzato ad accedere a procedure o dati sensibili. La sicurezza digitale è fatta indubbiamente di tecnologie ma anche di una nuova cultura da diffondere tra gli operatori. La trasformazione digitale è solo agli inizi, ma è fondamentale padroneggiare le tecniche per avere una chiara visione delle architetture da implementare per un manifatturiero di successo.

Giambattista Gruosso è docente al Politecnico di Milano

Iscriviti alla Newsletter

Iscriviti alla Newsletter

Condividi l'articolo

Scegli su quale Social Network vuoi condividere